في أكتوبر 2017، حصلت الروبوت «صوفيا» على الجنسية السعودية. وبغض النظر عما إذا كان ذلك الحدث بالفعل اعترافًا بحق الروبوت في الوجود، بل حتى حقه في المواطنة والحصول على جنسية دولة من دول العالم، أو كان مجرد حدث دعائي لا أكثر، ففي جميع الأحوال، أثار الحدث داخل أوساط الذكاء الاصطناعي مجددًا السؤال بشأن امتلاك الروبوتات حقوقًا أو واجبات، أي الحديث عن وضع الذكاء الاصطناعي في ظل إطار أخلاقي.

أخلاقيات الذكاء الاصطناعي فرع معاصر من الفلسفة، تحديدًا داخل تخصص «أخلاقيات التقانة»، تختص بالمسائل الأخلاقية المرتبطة بالروبوتات وأنماط الذكاء الاصطناعي المختلفة. تقوم أخلاقيات الذكاء الاصطناعي على دراسة وجهين مرتبطين بالقيمة الأخلاقية المتعلقة بهذا المجال: الأول هو علاقة الآلة بالإنسان، والآخر هو علاقة الإنسان بالآلة.

يهتم الوجه الأول، أي علاقة الآلة بالإنسان، بالسؤال عن الطرق التي يمكن أن تكون الآلات بواسطتها نافعة/ضارة للبشر، وهل ستملك الروبوتات، أو يجب أن تملك، منطقًا أخلاقيًّا؟ وفي هذه الحالة ما السلوك الأخلاقي الذي ينبغي أن تتبعه الروبوتات؟ وكيف يمكن استخدام الآلات في إيذاء البشر؟ وما الطرق الممكنة لتفادي هذا الخطر؟ والعكس، كيف يمكن استخدامهم في خدمة البشر ومنفعتهم؟

في حين ينصبُّ اهتمام الوجه الآخر من أخلاقيات الذكاء الاصطناعي، أي الجانب المَعنِي بعلاقة الإنسان بالآلة، بالكيفية والغاية التي من أجلها تُستخدَم الآلات، أي إنه مَعنِي بأسئلة من قبيل: كيف يصمم الإنسان الآلة؟ وكيف يبنيها؟ كيف يتعامل معها؟ والأهم، فيم يستخدمها؟ وهل توجد للآلة حقوق كما أن لها واجبات؟

حقوق الروبوت

يشير مصطلح «حقوق الروبوتات» إلى التزام البشر الأخلاقي تجاه الآلات التي يمتلكونها. فربما يكون للروبوت، إذا تطور بما يكفي، حق في الوجود كما للإنسان حق في الحياة. وتضمن بعض المؤسسات التي ترعى أبحاث الذكاء الاصطناعي حقوقًا أخرى للآلات كذلك في حال بلغت درجة عالية من الوعي، وهو ما لم يحدث بالطبع حتى الآن، لكنه ممكن، كحرية التعبير والمساواة أمام القانون.

يرتبط هذا في نظر بعض الباحثين بواجب الروبوت الأول في خدمة البشر. إذ إن حقوقًا مثل حق وجوده وحق أداء وظيفته يجب أن تتفق أولًا مع واجباته تجاهنا كبشر، وحقوق مثل حق الحياة وحق العمل عليها أن تتسق مع واجباته تجاه المجتمع الإنساني ككل، على أن هذا يرتبط في المقام الأول برؤية الباحث بمدى إمكان تطور الذكاء الاصطناعي نفسه.

مثلًا، يعتقد عالم الكمبيوتر وصانع برنامج «إليزا» الشهير، «جوزيف فايزنباوم»، أن الذكاء الصناعي لا ينبغى أبدًا أن يُستخدَم كبديل للإنسان في وظائف معينة، كخدمة العملاء والعلاج النفسي والعناية بالمسنين وحفظ الأمن والقضاء والشرطة، لأن هذه المهن تتطلب قدرًا من العناية والاحترام لا يقدر الذكاء الاصطناعي على توفيره، ولذلك لا يستطيع إنجاز تلك الوظائف، لأن الشعور الأصيل بالعاطفة والإيثار يلعب دورًا مهمًّا فيهم.

ترتبط هذه الرؤية بموقف فايزنباوم نفسه، المتشكك في إمكانيات الذكاء الاصطناعي. لكن إذا كان مشروع «الذكاء الاصطناعي القوي» في النهاية ممكنًا، واكتسب الروبوت وعيًا وشعورًا، فربما تصبح هذه الحجة غير سليمة، ويكون للروبوت، في هذه الحالة، جميع الحقوق التي للبشر.

إذا كان على الذكاء الاصطناعي العمل وفقًا لنموذج أخلاقي بعينه، فأي نموذج سيكون؟

يرتبط النقاش الجاري حاليًّا بشأن حقوق الروبوتات بالنقاش الجاري بشأن حقوق الحيوان، بما أن الذكاء الاصطناعي لم يبلغ بعد مرتبة البشر في الذكاء. وعلى سبيل المثال، عندما نشرت شركة «بوسطن دينامكس»، المصنعة للروبوتات، مقطع فيديو يُظهر الموظفين يركلون الروبوت «سبوت» لاختبار قدرته على حفظ توازنه، أصدرت مؤسسة حقوق الحيوان «PETA» بيانًا استنكاريًّا وصفت فيه هذا السلوك بأنه «غير مقبول».

تتعلق مسألة حقوق الروبوت إذًا بأكثر من عامل، منها قدرة الذكاء الاصطناعي على اكتساب الوعي والشعور، وما إذا كانت له حقوق، مع أنه دون درجة عالية من الوعي والشعور، مثلما ندافع مثلًا عن حقوق الحيوان، وأخيرًا ما إذا كانت حقوق الروبوت معلقة في النهاية على منفعته للإنسان، أم مستقلة عن خدمتها لهذه المنفعة. وتنقسم الآراء في الإجابة عن كل سؤال.

واجبات الروبوت

منذ اندلاع الثورة الصناعية بواسطة أيدي عاملة تدير الآلة، استُخدِمَت الماكينات في تسهيل العمل، وهذا أمر مختلف عن الذكاء الاصطناعي. إذ إن العمل في هذه الحالة يتم بواسطة الآلة فقط، دون تدخل من الإنسان، أي دون الحاجة إلى أيد عاملة. يعني هذا أن الآلة الذكية ستكون أكثر استقلالًا بدرجة كبيرة من أي آلة أخرى، وتطرح هذه الحقيقة أسئلة مهمة عن مسؤولياتها الأخلاقية، وقدرتها على تمييز الصواب من الخطأ.

حالما نبدأ التفكير بخصوص الإطار القيمي الأخلاقي الذي ينبغي على الذكاء الاصطناعي تبنيه، وبناء الروبوتات وفقًا له، لتعمل من خلاله، واكتسابها منطقًا أخلاقيًّا ما، تظهر هنا مشكلة أخرى في غاية الأهمية، تتعلق بموضوع الأخلاق نفسه وفلسفتها.

فإذا كان على الذكاء الاصطناعي العمل وفقًا لنموذج أخلاقي بعينه، فأي نموذج سيكون؟ إن النماذج والقيم الأخلاقية تختلف باختلاف الثقافات والشعوب والأديان، بل حتى داخل الشعب الواحد ربما تختلف من زمن إلى آخر، ومن مجموعة إلى أخرى، ناهيك باختلافها بين الأفراد أنفسهم.

هذا ما يميز القيمة الأخلاقية عن القيمة المعرفية أو العلمية. فإذا كانت هذه الأخيرة تستند إلى الواقع المباشر، فإن هذا يجعلها معرفة «موضوعية». أما الأخلاق، فربما تكون نسبية وغير مستندة إلى حقائق موضوعية، والدليل على ذلك اختلاف البشر في ما بينهم، واختلاف فلاسفة الأخلاق في رؤيتهم للصواب والخطأ. في هذه الحالة، أي نموذج أو نظرية أخلاقية يجب برمجة الذكاء الاصطناعي على أساسها؟

قدمت فلسفة الأخلاق عددًا من النظريات التي من الممكن أن يستفيد منها الذكاء الاصطناعي. لكنها نظريات تختلف وتتعارض في ما بينها، فلدينا الواجب الأخلاقي الكانطي الذي يرى السلوك الأخلاقي الخيِّر غاية في ذاته، أي إن الغاية لا تبرر الوسيلة بأي حال. وعلى النقيض من الأخلاق الكانطية، نجد المذهب النفعي مثلًا يرى أن الغاية تبرر الوسيلة، وأن المنفعة الناتجة عن فعل ما تصلح معيارًا للحكم بأخلاقية هذا الفعل من عدمه.

فإذا كنا نواجه مشكلة كبشر في كثرة النماذج والنظريات الأخلاقية وعدم اتفاقنا على أحكام أخلاقية قاطعة، فكيف يجب صناعة الروبوتات بطريقة تجعلها «أخلاقية»؟

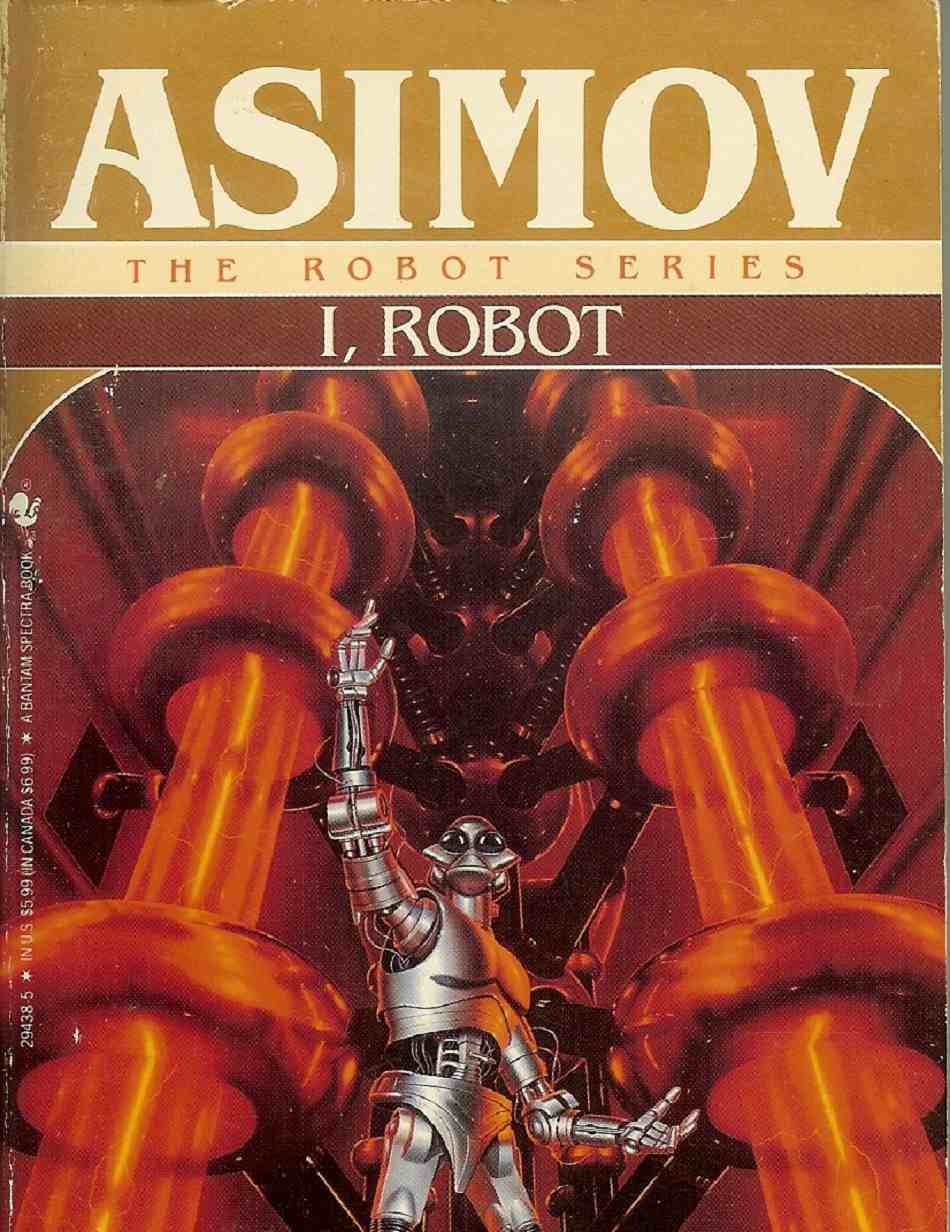

قوانين «أزيموف» الثلاث

حاول كاتب الخيال العلمي الشهير «إيزاك أزيموف» وضع قوانين أخلاقية للروبوتات تنظم حقوقها وواجباتها، وكذلك تحدد الأساس الذي عليه تصبح علاقة الإنسان بالآلة، والآلة بالإنسان، في تناغم، بعيدة عن أي أخطار أو مشكلات، فوضع ثلاثة قوانين تؤسس لأخلاقيات الروبوت التي ينبغي بناؤه، كي يبرمَج الذكاء الاصطناعي وفقًا لها، وهذه القوانين هي:

- لا يجوز للروبوت إيذاء بشري أو السكوت عما قد يسبب أذى له

- يجب على الروبوت إطاعة أوامر البشر إلا إذا تعارضت مع القانون الأول

- يجب على الروبوت المحافظة على بقائه إذا لم يتعارض ذلك مع القانونين الأول والثاني

أمضى أزيموف في مؤلفاته شوطًا طويلًا لفحص حدود وثغرات تلك القوانين وعواقبها، أي متى يمكن أن تتسبب في حدوث مفارقات أخلاقية وسلوك غير متوقع، ورأى في الأخير أن تلك القوانين ليست كافية بذاتها بشكل مطلق لتجنب أي أخطار ناجمة عن الذكاء الاصطناعي، لأن هناك مواقف قد ينتج عنها إيذاء الإنسان، في حين أنها تتسق مع تلك القوانين، وكان هذا دائم الحدوث في روايات أزيموف وقصصه القصيرة.

كان هذا السبب نفسه أيضًا مدخلًا لنقد مهندسي الذكاء الاصطناعي لقوانين أزيموف، بعد أن تشكَّل حولها تيار فكري أخلاقي يؤمن بضرورة بناء الروبوتات على أساس تلك القواعد.

أما أزيموف نفسه، فقد رأى أن تلك القوانين الثلاثة، برغم قصورها، فإنها تظل أفضل وسيلة لتقليص حجم التعارض المتوقَّع حدوثه بين الإنسان والآلة، ورأى أنه لا يمكن وضع قوانين قاطعة كافية بذاتها تمنع حدوث أي أضرار. لكن تظل تلك الثلاثة الأكثر عملية، حتى مع حدوث خروقات ذات عواقب قد تكون كارثية داخل نموذج أزيموف للقوانين الثلاثة.

تختلف الروبوتات المقاتلة اختلافًا جذريًّا عن الأسلحة التي يتحكم فيها الإنسان، لأنها تتميز بدرجة من استقلال القرار.

ربما يبدو الحديث كله حتى الآن دائرًا عن مستقبل بعيد، ويبدو لهذا السبب أقرب إلى الخيال العلمي من أي إشكالات واقعية، لكن النقد الأخير لقوانين أزيموف يعيد النقاش مجددًا إلى حدود الواقع الحاضر، ويتعلق هذا النقد باستخدام الذكاء الاصطناعي في التسلح. كثير من برامج الذكاء الاصطناعي الحالية يجري تطويرها لأغراض عسكرية، أي إنها مصممة خصوصًا لإيذاء البشر، ما يتعارض مع قانون أزيموف الأول، ومع نسقه الأخلاقي كله، ويدفع بالضرورة إلى التفكير في منطق مختلف لإدارة علاقة الإنسان بآلة شديدة التطور، قد تكون مصمَّمة أساسًا للقتل.

خطر التسلح

يُجري عدد من الدول الكبرى أبحاث ذكاء اصطناعي عسكرية، ويعني هذا تطوير روبوتات قادرة على الحركة في أرض المعركة وتنفيذ المهمات العسكرية في حالات الحرب. تسير هذه الأبحاث بوتيرة متسارعة، حتى إنه من المتوقَّع أن تمتلك الولايات المتحدة عددًا من الروبوتات المقاتلة يفوق عدد الجنود البشريين عام 2025.

يعني هذا بالضرورة تورط هذه الروبوتات في حصد أرواح البشر، ما يضعنا أمام أسئلة أكثر جزئية وإلحاحًا، من قبيل: ما مدى قدرة الآلة على التمييز بين المدنيين والعسكريين مثلًا؟ وما درجة الحرية الفعلية التي ستُمنح لهذا الذكاء الاصطناعي كي يتخذ قراراته الخاصة بناءً على تحليله المعلومات وتعلمه منها؟

تزداد المخاوف والدعاوى المعادية لهذا النوع من المشروعات خوفًا من خروجها الممكن أو المتوهَّم عن السيطرة، ما قد يعرِّض البشرية بالطبع لأخطار هائلة. تختلف الروبوتات المقاتلة اختلافًا جذريًّا عن الأسلحة التي يتحكم فيها الإنسان، لأنها تتميز بدرجة من استقلال القرار، وهذا القرار، في حالة الذكاء الاصطناعي العسكري، يتعلق بحفظ روح بشرية أو إهدارها.

لهذه الأسباب دعا كثير من الشخصيات العامة، مثل «إيلون ماسك» مؤسس شركة «تسلا»، و«بيل غيتس» مؤسس «مايكروسوفت»، والفيزيائي الراحل «ستيفن هوكنغ»، إلى التروي قليلًا وعدم الاندفاع في ما يتعلق بأبحاث الذكاء الاصطناعي وتطويره.

مع هذا، يظن بعض الباحثين أن التطبيقات العسكرية للذكاء الاصطناعي ربما تؤدي إلى تطور المجال كله بسرعة كبيرة، وأن تطويع الذكاء الاصطناعي لأغراض عسكرية أمر حتمي.

خلاصة رأي مناصري الذكاء الاصطناعي القوي أن أي تقنية قد تصبح خطرًا وتهدد بقاءنا إذا وقعت في الأيدي الخطأ.

تعاوَن إيلون ماسك وستيفن هوكنغ معًا لتمويل منظمة «مستقبل الحياة» التي تهدف، مثل مؤسسات تقنية ومعاهد بحثية أخرى غير هادفة للربح، إلى توجيه أنظار الرأي العام لأخطار مشروعات التسلح القائمة على الذكاء الصناعي، والدعوة إلى الالتفاف حول موقف مناهض لهذه المشروعات التي تقوم عليها جيوش الدول الكبرى، لأن أي تطور فعلي يحققه أحد الجيوش في هذا الصدد سيؤدي بطبيعة الحال إلى سباق تسلح ربما يستحيل إيقافه.

بدأت بوادر هذا في الظهور فعلًا بين الدول ذات الجيوش المتقدمة، مثل الولايات المتحدة وروسيا والصين. وتهدف بعض المؤسسات إلى تطوير ذكاء صناعي بديل، تحت اسم «الذكاء الاصطناعي الآمن» (Safe AI)، يضع نصب عينيه مصلحة الإنسان قبل كل شيء.

على العكس من ذلك، تُناصر بعض الشخصيات العامة التقدم التقني لأبحاث الذكاء الاصطناعي القوي، ولا تعتقد أنه يحمل أخطارًا فعلية للبشرية، وأبرز هؤلاء مارك زوكربيرغ مؤسس فيسبوك، الذي يتخذ موقفًا مؤيدًا للذكاء الاصطناعي القوي، حتى إنه دعا ماسك إلى العشاء في منزله من أجل مناقشة المسألة، لكن بقي الرجلان على موقفهما: يعتقد ماسك أن الذكاء الاصطناعي قد ينقلب عند نقطة من تطوره على البشر، فيما يعتقد زوكربرغ أنه سيكون دائمًا حليفًا للإنسان.

خلاصة رأي مناصري الذكاء الاصطناعي القوي أن أي تقنية قد تصبح خطرًا وتهدد بقاءنا إذا وقعت في الأيدي الخطأ، وأن الخطورة لا تتعلق بالذكاء الاصطناعي تحديدًا. لكن ماسك وهوكينغ ومن يأخذون نفس موقفهما، يعتقدون أن الذكاء الصناعي يختلف جوهريًّا عن أي تقنية أخرى قد تقع في الأيدي الخطأ أو لا تقع، لأن هذه التقنية تُصمَّم خصوصًا كي تتعلم من تجاربها الخاصة، وإذا تطورت بما يكفي ربما تصبح هي نفسها الأيدي الخطأ.

وترتبط هذه المخاوف بمفهوم «التفرد التقني» (Technological singularity)، وهو اللحظة المعينة من تطور الذكاء الاصطناعي التي يصبح فيها متقدمًا بما يكفي للاستقلال الكامل عن التحكم البشري، ومن ثمَّ العمل حتى على تطوير نفسه دون تدخل من الإنسان، بل والتفوق عليه، وهي لحظة يعتقد كل من إيلون ماسك وستيفن هوكنغ أنها قادمة.

التفرد التقني وموت الإنسان

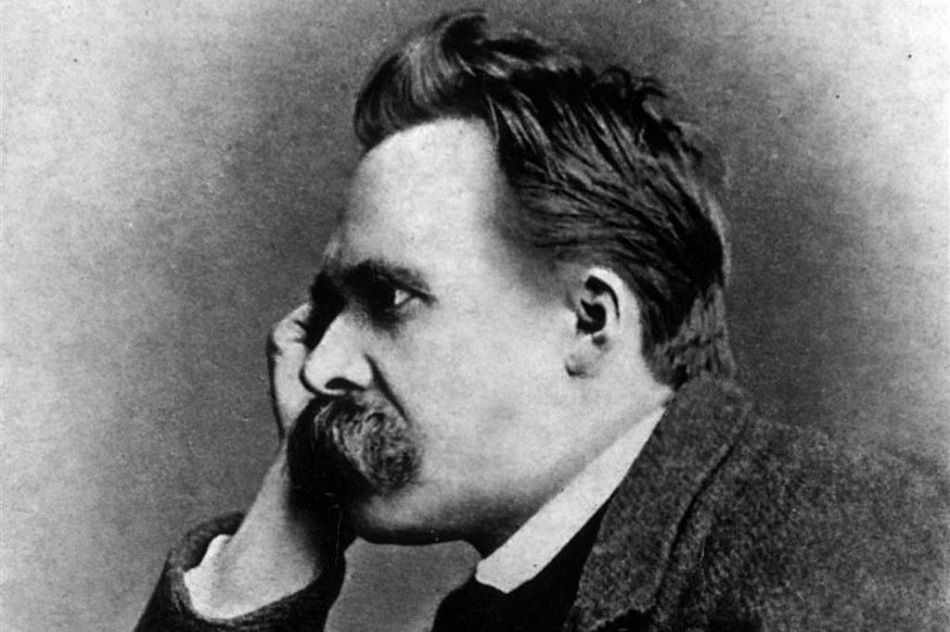

أعلن الفيلسوف الألماني فريدريك نيتشه، في أواخر القرن التاسع عشر، أن «الله قد مات»، ليعبر عما آلت إليه الحضارة الأوروبية آنذاك من انهيار لرؤية العالم الدينية، وحالة العدمية التي أصبحت ملازمة للإنسان الحديث. لهذا السبب دشن نيتشه هدفًا جديدًا للبشرية، يعيدها إلى حظيرة المعنى، ويهب وجودها غاية، وهو «السوبرمان» أو الإنسان الأعلى.

السوبرمان في فلسفة نيتشه شخص يتجاوز الإنسان الحالي في كل شيء، فهو يستطيع بناء نسق جديد تمامًا من القيمة، وهو مقدمة لجيل جديد تمامًا من البشر، ويملك كل أدوات المعرفة اللازمة التي تمكنه من تغيير واقعه. فهل يمكن أن يكون الذكاء الاصطناعي سوبرمان نيتشه، بدلًا من الإنسان المتطور الذي تصوره؟ وهل يؤدي قدوم هذا السوبرمان الفعلي إلى موت الإنسان هذه المرة، بدلًا من موت الله الذي أشار إليه الفيلسوف الألماني؟

يستطيع الذكاء الاصطناعي التعلم باستمرار عن طريق المعطيات المتوفرة في البيئة من حوله، وذلك من خلال التفاعل معها. والنوع المقصود هنا من الذكاء الاصطناعي هو القوي، لأن الضعيف يكون مبرمجًا على مهمة واحدة معينة، ويعجز عن اكتساب أي خبرات أخرى غيرها، حتى إنه قد يعجز عن تأدية مهمته خارج البيئة المناسبة. أما الذكاء الاصطناعي القوي، فقادر على تحصيل أكبر قدر من المعلومات من حوله والإفادة منها، وهذا يعني أنه قادر على تطوير سلوكه باستمرار ليتناسب مع المعطيات والمواقف الجديدة المختلفة.

هنا تكمن خطورة فكرة التفرد التقني، فكما أن التفرد في فيزياء الثقوب السوداء نقطة في نسيج الكون يصبح عندها مقدار الجاذبية والكثافة لانهائيين، إلى الحد الذي يتعذر فيه على أي نظام إحداثي التعرف على الظواهر أو وصفها، يشير التفرد التقني إلى نمو الذكاء الاصطناعي وتطوره القوي إلى الحد الذي يصعب فيه استيعابه أو تبطل كل محاولات الإنسان لفهمه، لأنه تفوَّق عليه بالفعل، أي إن أي وسيلة معرفية يمتلكها الإنسان، ويستطيع استخدامها، ستكون أقل تطورًا، وأضعف من الإحاطة بالذكاء الصناعي القوي.

يتعجب بيل غيتس من أن كثيرًا من الناس لا يبالون بتلك المشكلة، بل إن رد الفعل ربما يبلغ الاستخفاف بالأخطار التي قد يتسبب فيها الذكاء الاصطناعي القوي، وهو استخفاف يعتبر القلق من الذكاء الصناعي يشبه «القلق من الخطر الناجم عن مشكلة الزيادة السكانية على كوكب المريخ قبل أن تطأه أقدامنا».

بالنسبة إلى كثير من الباحثين تبدو هذه المخاوف مفرطة في التنظير ومنفصلة عن الواقع، وربما يراها بعضهم معطلة للبحث دون دواعٍ حقيقية. ولهذا السبب تلقَّى هوكينغ مثلًا نقدًا حادًّا لأن الذكاء الصناعي يهب له القدرة على التواصل، في الوقت الذي يهاجمه فيه ويسميه خطرًا على مستقبل البشرية.